Qu’ils portent sur la facilité de faire des affaires, le coût de la vie ou la qualité de l’enseignement supérieur, les classements internationaux de compétitivité en tous genres ont le vent en poupe. Les performances souvent stagnantes du Luxembourg dans ces rankings peuvent surprendre à première vue parce qu’après tout le Grand-Duché est doté d’atouts certains. Ainsi, le World Economic Forum (WEF) place le pays au 20e rang dans son plus récent classement annuel de compétitivité, alors que le trio de tête paraît presque immuable : la Suisse caracole à la première place depuis sept ans, suivie de Singapour et des Etats-Unis. A chaque nouvelle édition, (re)montent à la surface une série d’interrogations : Quelle est la réalité sous-jacente de ce classement ? Nos décideurs politiques doivent-ils repenser leur stratégie en matière de politique économique ? Ou encore : Quels sont les chantiers à mener pour combler nos apparentes « lacunes » ?

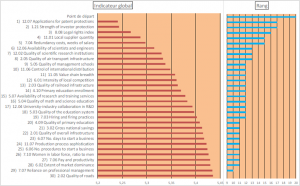

Une idée du mois de la fondation IDEA (IDM) estime que le Luxembourg pourrait accéder le plus efficacement possible au top 10 du classement WEF en agissant sur les 30 indicateurs suivants :

Graphique 1 : Démarche itérative « Top 10 » WEF d’IDEA

L’objectif de cette contribution est de questionner l’utilité du classement WEF dans sa capacité à aider un pays, en l’occurrence le Luxembourg, à améliorer sa compétitivité. A cette fin, nous repartons de l’exercice IDEA précité, et nous nous demandons si les 30 indicateurs savamment identifiés comme permettant au pays de se hisser dans le top 10 sont utiles à une réforme orientée compétitivité.

La réponse apparaît mitigée alors que plusieurs réformes de nature (trop souvent) cosmétique sont en effet envisageables. Ces réformes valent-elles la peine d’être vécues ? Sans doute car, si seulement une infime partie de celles-ci améliore effectivement la compétitivité en pratique, un exercice national « arriviste », utilitariste de renforcement de la compétitivité a le mérite non seulement de faire entrer le pays dans la « cour des grands » (avec de potentielles retombées en termes d’investissements directs notamment), mais également de permettre aux administrations concernées de comprendre et de s’approprier le fonctionnement d’indicateurs relevant de leurs compétences, aussi imparfaits soient-ils.

Une majorité d’indicateurs « soft » plutôt « bof »

A première vue, 70% des 30 indicateurs à influencer en priorité, soit 21 au total, sont issus de l’enquête d’opinions des responsables d’entreprises du WEF. L’étude du WEF combine en effet données statistiques (celles qui sont observées, ou « hard data ») et enquêtes d’opinions captant les perceptions des responsables d’entreprises (« soft data »). Interrogés dans le cadre de l’étude, ces derniers répondent à des questions du type suivant, par exemple en ce qui concerne la R&D[1] : « In your country, to what extent are scientists and engineers available? [1 = not at all ; 7 = widely available] », ou encore « In your country, how do you assess the quality of scientific research institutions? [1 = extremely poor/among the worst in the world ; 7 = extremely good/among the best in the world] ».

Le recours à ce type de questions pose tout d’abord plusieurs problèmes en cas de comparaison entre pays. Les normes culturelles et perceptions nationales variant fortement d’une contrée à l’autre, la même question peut être interprétée différemment selon les zones géographiques, ce qui peut en compliquer la comparaison. De plus, certaines nations sont naturellement plus optimistes que d’autres vis-à-vis d’elles-mêmes. C’est le cas notable de Singapour, considéré par certains comme étant « obsédé » par son propre classement[2] (dans lesquels il se positionne d’ailleurs toujours très bien). Un effet d’amplification entre donc en jeu : plus un pays y apparaît être relativement bien classé, plus les responsables interrogés ont tendance à édulcorer leurs réponses… et inversement. Enfin, un effet dit d’« annonce » peut interférer dans l’interprétation des résultats d’enquêtes. Les réponses données peuvent en effet être influencées par une simple déclaration politique au timing bien placé, ou encore par l’actualité.

Mais les problèmes ne s’arrêtent pas là. Outre la question de la comparabilité de ce type d’indicateurs entre pays, celle de leur validité mérite d’être posée.

Une lecture de l’annexe méthodologique du rapport WEF laisse en effet apparaître que de nombreux pays, dont les plus petits comme le Luxembourg mais pas seulement[3], s’appuient sur un échantillon de responsables d’entreprises relativement restreint, et donc potentiellement peu représentatif de l’économie nationale. Le risque de biais statistique dû à un effet d’auto-sélection est donc grand, avec à la clé une forte volatilité des données récoltées et des résultats tronqués. Quel responsable politique voudrait donc entamer une réforme orientée compétitivité sur base des doléances d’un groupe restreint de responsables d’entreprises particulièrement remontés contre le système (ou au contraire, hautement satisfaits) qui, à travers ce mécanisme d’auto-sélection, ont pris la peine de répondre à coups de « 1 » et de « 2 » (ou à coups de « 6 » et « 7 ») aux questions posées ?

Et quand bien même un responsable politique voudrait s’attaquer à un indicateur de perception mal positionné, il ne saurait simplement pas par quoi commencer. Les questions issues d’enquêtes d’opinions sont formulées de manière très générale, et elles ne renseignent donc pas sur les aspects à améliorer en cas de réforme (en jargon économique, on dit qu’elles ne sont pas « actionnables »). Les données issues d’enquêtes d’opinions peuvent enfin être victimes d’effets d’annonce. Une déclaration gouvernementale ou une conférence de presse claironnant à tout va l’intention de réformer peut en effet influencer provisoirement à la hausse un indicateur « soft » dans un pays donné à un moment donné, sans qu’il y ait de véritables suites sur le terrain.

Des indicateurs statistiques pas très pratiques

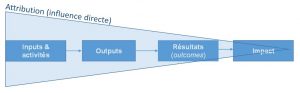

Les 9 indicateurs restants identifiés par IDEA se composent de données statistiques objectivement mesurables (« hard data ») et comparables entre pays. Dans la « chaîne de causalité » des différents effets de l’action publique, ceux-ci relèvent tant de l’output que du résultat (« outcome ») et de l’impact.

Chaîne de causalité de l’action publique

Sur ces 9 indicateurs, quatre s’avèrent non-actionnables. Ils révèlent où l’on se situe objectivement par rapport à d’autres pays (ce qui a tout de même le mérite de permettre l’identification d’éventuelles lacunes), mais ils ne nous disent pas comment nous améliorer.

Parmi eux, un premier indicateur est communément considéré comme relevant de l’output d’activités de R&D, à savoir le 1er indicateur de la liste IDEA mesurant le dépôt de brevets[4]. Dans la littérature économique, cet indicateur permet de prédir la propension à innover d’un pays, et il est fortement corrélé avec sa performance économique. L’OCDE prévient toutefois qu’il ne faut pas considérer ce type d’indicateur de manière isolée[5] car beaucoup de brevets n’aboutissent pas (et, inversement, de nombreuses innovations ne sont pas brevetées). Une analyse complémentaire de triangulation de données (indicateurs statistiques, questionnaires représentatifs et entretiens approfondis) est donc requise avant de tirer toute conclusion sur un système d’innovation donné. Pris en isolation comme ici, cet indicateur ne nous apprend pas grand-chose donc.

Un second indicateur non-actionnable est généralement considéré comme relevant de l’outcome (résultat) de politiques d’éducation diverses, soit le 14e indicateur de la liste IDEA relatif au taux d’accès à l’éducation primaire[6]. Le fait que cet indicateur ait été identifié par IDEA est interpellant en soi. En tant que pays développé, le Luxembourg ne devrait tout bonnement pas être concerné par cet indicateur, contrairement au Rwanda par exemple. Et d’ailleurs, pourquoi ressort-il, selon l’analyse IDEA, comme un point faible ? Tous les petits luxembourgeois ne vont-ils donc pas à l’école? Ne sommes-nous pas face à un biais ou un « artefact statistique », à l’instar de l’indicateur du taux d’accès à l’éducation supérieure relevé par IDEA dans son IDM? Ces deux indicateurs mériteraient d’être investigués par les autorités en charge de l’éducation, et nous y reviendrons.

Les deux indicateurs non-actionnables suivants relèvent de l’impact, à savoir les 21e et 26e indicateurs de la liste IDEA des taux d’épargne intérieur brut (en % du PIB) et de participation des femmes au marché du travail[7]. Tout comme le taux d’accès à l’éducation primaire, ces indicateurs sont situés en aval de la chaîne de causalité et, de ce fait, difficilement attribuables à un politique donnée. Le taux de participation des femmes au marché du travail est par exemple le fruit de diverses politiques familiales, mais également de facteurs culturels et de forces internationales comme les crises économiques ou les conflits armés. Le taux d’épargne intérieur brut est encore plus difficilement attribuable à une action économique donnée et relève tant de l’impact macroéconomique général que d’éléments de nature sociologique et culturelle.

Enfin, cinq indicateurs issus du rapport « Doing Business » de la Banque Mondiale relèvent de l’outcome (résultat) d’une ou plusieurs politiques publiques données[8]. Ils apparaissent à priori utiles à une réforme orientée compétitivité (ils sont actionnables). Ils sont d’autant plus intéressants qu’à l’instar de l’indicateur d’output de dépôt de brevets déjà mentionné, une amélioration de ceux-ci conduirait à d’importants « sauts » de classement.

Des indicateurs Doing Business intéressants… mais imparfaits

Le classement « Doing Business » (DB) de facilité de faire des affaires (« ease of doing business ») a de nombreux détracteurs à travers le monde, et une revue exhaustive de toutes ces critiques sera épargnée ici[9]. Il est néanmoins intéressant à plusieurs égards.

Premièrement, s’il est vrai que certains de ses sous-indicateurs relèvent de l’input (n’indiquant en rien la qualité intrinsèque d’une politique donnée), une grande partie de ceux-ci ont trait aux résultats (outcomes) des politiques publiques, soit des conséquences, sur le terrain, de diverses réformes. L’outcome est alléchant à notre niveau d’analyse, car il mesure le changement de comportement des acteurs visés par une réforme donnée, qu’elle soit formellement inscrite dans la loi ou non. Un indicateur d’outcome est donc plus révélateur qu’un indicateur d’input (ou d’output) mais, contrairement à l’impact, il n’est pas trop éloigné dans la chaîne de causalité d’une politique publique que pour se voir « noyé » parmi d’autres facteurs d’influence.

Nombreux sont les sous-indicateurs DB qui tiennent compte du coût et/ou du temps nécessaires pour s’acquitter d’une procédure, par exemple pour l’obtention d’une autorisation d’établissement ou pour se séparer d’un employé. Il s’agit bien là de l’outcome : si trois mois en moyenne sont requis pour obtenir une autorisation X dans un pays B, contre seulement deux semaines dans un pays A, c’est que le système du pays B permet ce type de lenteur (comportement) en pratique. De plus, avec ses études de cas détaillées pour chaque pays, la base de données DB permet d’identifier les goulots d’étranglement. Toujours dans notre exemple, plusieurs administrations du pays B avalisent une demande d’autorisation l’une à la suite de l’autre, sans limite de temps, alors que dans le pays A celles-ci avalisent une même demande simultanément, et une limite de temps leur est imposée.

Ces indicateurs DB sont donc bels et bien actionnables, et une lecture détaillée des études de cas standardisées appliquées à chaque pays permet d’identifier où les forces et les faiblesses de chacun se trouvent. Mais ce n’est pas tout.

Contrairement aux indicateurs « soft », les indicateurs DB ne sont pas le fruit de sondages trop peu représentatifs du monde des affaires. Parfois, ils sont obtenus en regardant ce qui est inscrit dans la loi (input). Souvent, ils sont le fruit de sondages d’experts nationaux selon une méthode que l’on pourrait qualifier de delphique : plusieurs d’entre eux sont contactés, dans chaque pays, par l’équipe DB de la Banque Mondiale, par exemple afin de vérifier le temps nécessaire à l’obtention d’un permis donné. Lorsque tous les experts reviennent avec une même réponse (« 40 jours environ »), celle-ci est considérée finale. Par contre, s’ils se contredisent, l’équipe DB les recontacte individuellement en leur demandant de justifier les divergences jusqu’à ce qu’une réponse finale soit retenue. Il ne s’agit donc pas d’indicateurs « soft » et, bien qu’il ne s’agisse pas d’indicateurs purement statistiques non plus, ils sont considérés comme « hard data » car ils sont quantifiés de manière relativement objective[10].

Il est vrai que, pour les sous-indicateurs d’input, une modification purement cosmétique (dans la loi) peut suffire sans qu’il n’y ait de véritable changement pour les entreprises sur le terrain. La Russie a d’ailleurs été pointée du doigt pour avoir systématiquement influencé ces indicateurs d’input afin d’améliorer, avec succès, son classement DB[11]. Cette façon de procéder n’est pas possible pour les indicateurs d’outcome, et seul un changement d’approche effectif de la part d’une (ou plusieurs) administration(s) peut apporter non seulement un gain de classement, mais également de potentiels bénéfices pour les entreprises en pratique.

Si les indicateurs DB sont critiqués partout dans le monde, ils sont particulièrement mal aimés au Luxembourg. Pourquoi donc notre pays, avec sa Place Financière si dynamique, est-il si médiocrement classé, par exemple dans les indicateurs DB « strenght of investor protection » et « legal right index » repris au classement WEF ? Une amélioration dans ces indicateurs permettrait pourtant au pays de passer de la 17e à la 16e place dans ce classement, selon l’analyse IDEA.

Une revue rapide de l’étude de cas DB de « protection des investisseurs » appliquée au Luxembourg révèle que cet indicateur concerne plus particulièrement la protection des actionnaires minoritaires, et consiste en une série d’informations relatives à la transparence vis-à-vis de ceux-ci et à la facilité pour eux de faire valoir leurs intérêts face aux autres actionnaires[12]. En apprenant la contre-performance du Luxembourg en la matière, une avocate chevronnée spécialiste en contentieux corporate sur la Place se dit « peu surprise ». Selon elle, si les actionnaires minoritaires luxembourgeois réussissent à faire valoir leurs droits autant qu’ailleurs, les procédures de résolution de litiges sont particulièrement lourdes et lentes au Luxembourg, ce qui mine en effet l’attractivité du pays dans ce domaine[13].

Une revue rapide de l’étude de cas DB relative aux « prérogatives juridiques » appliquée au Luxembourg révèle ensuite que cet indicateur concerne plus particulièrement la question des collatéraux et, notamment (là où le Luxembourg est particulièrement mal loti), la catégorisation de ceux-ci selon leur degré de liquidité dans un registre national sur base d’un cadre légal unifié[14]. En apprenant la pauvre performance du Luxembourg en la matière, un CFO aguerri de la Place confirme l’absence de tels outils au Luxembourg tout en insistant que ce n’est pas problématique. Selon lui, les fondamentaux de la protection des créanciers sont évidemment bien présents et la pratique s’auto-suffit. Mais si cela pénalise fortement le pays dans les ranking de compétitivité, alors « pourquoi ne pas se pencher sur la question » ? Ne faudrait-il pas tenter de remédier à cette contreperformance de manière pragmatique ?

A chaque administration la responsabilité de comprendre « ses » indicateurs et d’agir

La question est donc posée : les ministères et administrations concernés par ces deux indicateurs DB, ainsi d’ailleurs que le MENFP au sujet des taux d’accès à l’éducation primaire et, surtout, tertiaire, sont-ils au courant ? Réalisent-il qu’un courrier officiel expliquant qu’une majorité de jeunes résidant à Luxembourg étudie à l’étranger (avec pour conséquence un taux d’accès à l’éducation tertiaire erroné) pourrait mener à une correction statistique au niveau international et une amélioration significative de classement ? Réalisent-ils que, souvent, une réforme purement cosmétique suffit et que, parfois même, une réforme incitée par un ranking médiocre améliore véritablement la vie des entreprises sur le terrain ?

Rien n’est moins sûr. Ce dont nous sommes certains par contre, c’est du rôle que pourrait jouer l’Observatoire luxembourgeois de la compétitivité sous ses missions 1 et 2 de « collecte, analyse et comparaison des informations existantes relatives à la compétitivité au niveau national et international [et de] diffusion ciblée d’informations sélectionnées et traitées utiles à la prise de décision stratégique ». Dans cette double mission, l’expérience de Singapour pourrait s’avérer utile.

Comme le montrent Lin et Ewing-Chow dans leur publication (2016) décrivant la véritable traque aux indicateurs DB par les autorités singapouriennes[15], le Ministère de l’Industrie et du Commerce (MIT) est chargé de diriger et coordonner le suivi et l’analyse de son classement DB national annuel. Les administrations concernées par les indicateurs mal positionnés sont ensuite chargées de mener les réformes là où il faut. Elles « mènent des analyses approfondies de leurs indicateurs respectifs, ainsi que des études comparatives de la performance d’autres juridictions », et elles « identifient les domaines dans lesquels une meilleure mise en œuvre ou une réforme légale est nécessaire et considèrent en interne les diverses propositions d’actions à mener ».

Lin et Ewing-Chow ne dressent pas pour autant de portrait idyllique sur la façon dont les indicateurs DB sont littéralement « gérés » à Singapour. Ils se montrent même très critiques vis-à-vis de DB en général et de son indicateur de protection des investisseurs minoritaires en particulier. Selon eux, l’étude de cas DB standardisée dans ce domaine ne réussit pas à capturer les spécificités de Singapour, et nombreux sont les aspects essentiels de la protection des investisseurs minoritaires dans le pays qui se voient tout bonnement ignorés par la Banque Mondiale. Et c’est bien là la plus grande critique communément adressée à DB : des indicateurs standardisés à l’extrême ne parviendront jamais à capturer certaines dimensions pourtant cruciales à la facilité de faire des affaires dans un pays, propres à son contexte institutionnel, historique, culturel, informel et même géographique unique.

Qu’à cela ne tienne ! Singapour avance avec ses réformes, tantôt cosmétiques tantôt imparfaites, et continue de caracoler en tête des classements les plus consultés à l’international.

Faut-il pour autant émuler telle qu’elle chez nous une approche à ce point « arriviste » et utilitariste ?

L’approche managériale de Singapour a tout de même le mérite de permettre aux administrations concernées de comprendre et de s’approprier le fonctionnement d’indicateurs relevant de leurs compétences, aussi imparfaits soient-ils. De plus, l’Observatoire de la compétitivité est déjà en place et ses missions semblent suffisamment bien, voire parfaitement, formulées pour lui faire endosser un rôle de leader à l’instar du MIT singapourien. L’approche des pays nordiques et de la Suisse (pays qui, à l’instar de Singapour, dominent les classements internationaux) en la matière n’est pas documentée ici, mais il y a fort à parier… qu’il n’y en a pas, et qu’une bonne dose de pragmatisme dans les administrations helvético-nordiques permette de telles prouesses de classement à l’international.

« Let’s make it happen », pour reprendre le nouveau slogan national officiel. Il ne tient qu’à nos responsables économiques de choisir les moyens de leurs ambitions.

[1] Indicateurs 6 et 7 identifiés par IDEA permettant au Luxembourg de se hisser à la 13e place du classement WEF.

[2] Rylance B. Juin 2011. « Assuaging Singapore’s Obsession with Comparative Ranking » sur le site www.economywatch.com et disponible sur ce lien.

[3] Voir notamment le WEF « Global Competitiveness Report 2016-2017 » p. 78 pour un descriptif méthodologique.

[4] Indicateur WEF 12.07 « Patent Cooperation Treaty (PCT) patent applications » (source : OCDE).

[5] OCDE. 2009. OECD Patent Statistics Manual. Paris : OCDE.

[6] Indicateur WEF 4.10 dit « Primary education enrollment rate » issus de sources multiples (UNESCO, OCDE, Banque Mondiale, UNICEF et UNDP). Dans l’IDM d’IDEA, une amélioration de celui-ci en conjonction avec 11 autres indicateurs permettrait au Luxembourg d’atteindre la 12e position du classement WEF.

[7] Indicateurs WEF 3.02 et 7.10 dits « Gross national savings » et « Female participation in the labor force » issus respectivement des bases de données du FMI et de l’OIT. Dans l’IDM d’IDEA, une amélioration de ceux-ci en conjonction avec 8 autres indicateurs permettrait au Luxembourg d’atteindre la 10e place du classement WEF.

[8] A savoir les indicateur n°2, 3, 5, 23 et 25 de la liste d’IDEA, respectivement les indicateurs Doing Business 1.21 « Strenght of investor protection », 8.08 « Legal rights index », 7.04 « Redundancy costs », 6.07 « Time required to start a business » et 6.06 « Number of procedures required to start a business ».

[9] Voir un récapitulatif récent de la critique internationale dans Lin et Ewing-Chow (2016) ci-dessous.

[10] Ce qui dépend évidemment de la diligence de l’équipe DB dans son travail delphique, tout comme les indicateurs purement statistiques dépendent du professionnalisme et de l’intégrité des instituts nationaux de statistiques chargés de les récolter.

[11] Stichelmans, T. Octobre 2015. « Doing Business 2016’s reformed indicator will favour land-grabbing » dans le « European Network on Debt and Development », disponible sur ce lien.

[12] La description de l’étude de cas DB standardisée de protection des actionnaires minoritaires se trouve sur ce lien, et l’étude de cas appliquée au Luxembourg pour un score finale de 4.5/10 (ce qui correspond à une 122e place sur 189 économies dans le rapport DB), repris tel quel dans le classement WEF, est disponible sur ce lien.

[13] A noter que la nouvelle loi du 10 août 2016 modernisant le droit des sociétés lève, du moins en partie, certaines lenteurs du système (ce qui devrait se répercuter dans les prochains classements DB).

[14] La description de l’étude de cas DB standardisée de relative aux collatéraux se trouve sur ce lien, et l’étude de cas appliquée au Luxembourg pour un score finale de 3/12 (ce qui place le Luxembourg à une 167e place sur 189 économies, une fois le score combiné avec d’autres indicateurs dans le rapport DB), repris tel quel dans le classement WEF, est disponible sur ce lien.

[15] Lin L. & Ewing-Chow M. Mars, 2016. « The Doing Business Index on Minority Investor Protection : The Case of Singapore » dans le « Singapore Journal of Legal Studies » (pp. 46-69), disponible sur ce lien.

Chers auteurs,

Tout d’abord un grand merci pour cet article intéressant. Je me posais souvent la question moi-même à savoir, à quoi servent tous ces rapports plutôt divergents sur la compétitivité du Luxembourg? En fin d’année, en effet, circulent pas moins de 3 rapports sur le classement du Luxembourg en terme de compétitivité: le rapport de la WEF, celui de l’UEL et celui de l’Observatoire du même nom. L’on y perd son latin!

Souvent, pour ne pas dire toujours, ces classements concernant la compétitivité sont très “data oriented”, l’on fait avec les données disponibles et tout ceci reste très descriptif: un indicateur en plus ou en moins peut changer radicalement le classement.

Lorsqu’on jette un coup d’œil à la “chaine de causalité de l’action publique”, ne pourrait-on pas modéliser la compétitivité dans une approche “de régression” où les “inputs” seraient considérés comme les variables explicatives (les régresseurs), les “outputs” seraient donc les variables expliquées, les “outcomes” seraient les résultats et les “impacts” seraient similaires à des effets partiels (ou marginaux)? Ces regressions proviendraient, dans la mesure du possible, de la théorie économique et les indices de compétitivité sur lesquels se fonderaient les classements pourraient donc jouer un rôle similaire à la notion de Total Factor Productivity à la Solow. L’avantage majeur de l’approche de régression serait que l’on pourrait s’appuyer sur une approche plutôt objective et composite, à l’instar de l’article de Agnès Bennasy-Quéré et de Xavier Ragot (voir ci-après)

http://www.cae-eco.fr/IMG/pdf/cae-note021v3.pdf

Ceci dit, il y encore du chemin à faire pour comprendre la notion de compétitivité dans le cas du Luxembourg, et je ne crains que ça soit l’affaire d’une seule institution, aussi implantée soit-elle. Parfois vaut mieux prendre du recul et ne pas avoir tout le temps la tête dedans pour mieux comprendre…

Cordialement

PR

Cher Monsieur,

Merci pour votre … input !

Les classements internationaux de compétitivités les plus connus fonctionnent en effet selon leurs propres « cadres de compétitivité » (« competitiveness framework ») composés d’un mélange d’indicateurs d’input, output, outcome et impact organisés par « piliers » : un pilier « institutions », un autre « infrastructures », un autre « innovation », etc. selon l’idée que la croissance/prospérité est le produit du travail (L) et du capital (K), mais également d’un « résiduel » multidimensionnel de productivité (institutions, innovation, organisation des marchés, etc.). Le tout est typiquement agrégé en un indexe composite unique, ainsi qu’en plusieurs sous-indexes thématiques, ceci à des fins de comparaisons et de classements.

Certains de ces classements internationaux, en tout cas les plus médiatisés comme le WEF et IMD, « justifient » leurs choix de cadres de compétitivité en se référant à des théories économiques diverses (d’autres ne prennent pas cette peine). Le cadre WEF est d’ailleurs notoirement connu pour être adapté du « modèle du diamant » (« Diamond’s model ») de Michael Porter. Plus de détails quant à l’adaptation de ce modèle, un mélange de facteurs macros, micros et de « endowments » (location géographique et ressources naturelles), sont fournis dans l’édition 2007-2008 du rapport.

Depuis le temps que ces classements existent, plusieurs chercheurs ont déjà eu l’occasion de s’adonner à différentes analyses économétriques de ces classements (voir un bon récapitulatif dans Ochel & Rohn, 2006, par exemple). Ils ont notamment analysé la relation entre la croissance du PIB et les indexes de compétitivité les plus connus (WEF et IMD). Mais dû à un « effet de rattrapage » dans les économies émergentes, la corrélation entre ces deux mesures s’avère plutôt faible, voire même négative. Une telle approche pose deux problèmes cependant.

Le premier est celui de la multicolinéarité. Au vu des nombreuses variables qui composent les indices agrégés de compétitivité et du fait que plusieurs d’entre elles (les « hard data ») sont rapportées au PIB, le double comptage est inévitable.

Plus important : Dans ces classements, l’on constate un mélange cacophonique de données (indicateurs) de type input / output / outcome / impact tantôt relatifs à une dimension de la compétitivité (l’éducation), tantôt relatif à une autre aspect de celle-ci (l’innovation) et ainsi de suite… ne permettant toutefois pas de capturer complètement chacune de ces dimensions à un tel niveau d’agrégation.

Le mieux (et c’est là que nous vous rejoignons) est sans doute de ne pas vouloir agréger les données à tout prix, et de se « contenter » d’estimer une (sous)dimension à la fois, en régressant des résultats (outcomes) ou impacts attendus (variables Y) sur différents inputs et outputs de politiques publiques données (variables X). C’est d’ailleurs ce à quoi les chercheurs s’adonnent généralement dans leurs domaines de spécialisation respectifs. Par exemple, en matière d’éducation (une dimension de compétitivité parmi bien d’autres), les résultats aux tests PISA (outcome) et d’autres mesures de résultat plus qualitatives (ex. confiance qu’ont les élèves en leurs propres capacités) sont comparés à différentes mesures d’input (dépenses publiques par élève) ou d’output (ratio moyen profs / élèves par classe). Des analyses relatives aux questions d’équité sont également opérées, par exemple en comparant les résultats d’enfants issus de milieux socio-économiques défavorisés aux autres, ce qui permet d’entrevoir l’impact… (le mesurer requerrait un suivi longitudinal de cohortes d’élèves sur plusieurs décennies).

Quoiqu’il en soit, et comme vous le soulevez, la notion de compétitivité est complexe et est le fruit de facteurs de plus en plus intangibles, comme la logistique, la finance, la communication ou encore la capacité d’allouer le talent (voir à ce titre : « The future of productivity », une réflexion menée par l’OCDE en 2015). Vouloir la mesurer et la comparer à tout prix est compréhensible (c’est un réflexe très « humain » après tout), mais il faut garder à l’esprit les limites inhérentes à ce type d’exercice.